Der EU AI Act sorgt derzeit für große Unsicherheit in der deutschen und europäischen Wirtschaft und hat ausnahmsweise mal nichts mit europäischer Gasversorgung zu tun. Viele Unternehmen (oder ihre Unternehmer) wissen nicht, ob und in welchem Umfang sie von der neuen europäischen KI-Verordnung betroffen sind. Während große Tech-Konzerne wie OpenAI, Meta und Google längst mit der Umsetzung begonnen haben, stellen sich besonders kleinere SaaS-Anbieter, Startups und mittelständische Betriebe in Deutschland eine zentrale Frage: Für wen gilt der EU AI Act überhaupt? Was muss ich beachten? Und welche Strafen drohen bei Nichteinhaltung der Regelungen?

Mit diesem Beitrag stelle ich eine Entscheidungshilfe bereit, mit der die Antwort auf diese Frage leichter fallen sollte. Doch vorweg: in vielen Fällen lautet die Antwort: ja – direkt oder indirekt. Denn der AI Act betrifft nicht nur Entwickler von KI-Systemen, sondern auch alle Unternehmen, die solche Systeme nutzen, vertreiben oder (integriert in Produkte) in den europäischen Markt einführen.

Was regelt der EU AI Act überhaupt?

Der EU AI Act ist das erste umfassende gesetzliche Flaggschiff zur Regulierung des KI-Einsatzes Künstlicher Intelligenz weltweit. Damit ist die EU zwar alles andere als technischer Vorreiter in der KI-Entwicklung – aber immerhin ganz weit vorne in der Regulierung! Ziel der Verordnung ist es, den sicheren, transparenten und verantwortungsvollen Einsatz von KI-Systemen innerhalb der Europäischen Union sicherzustellen.

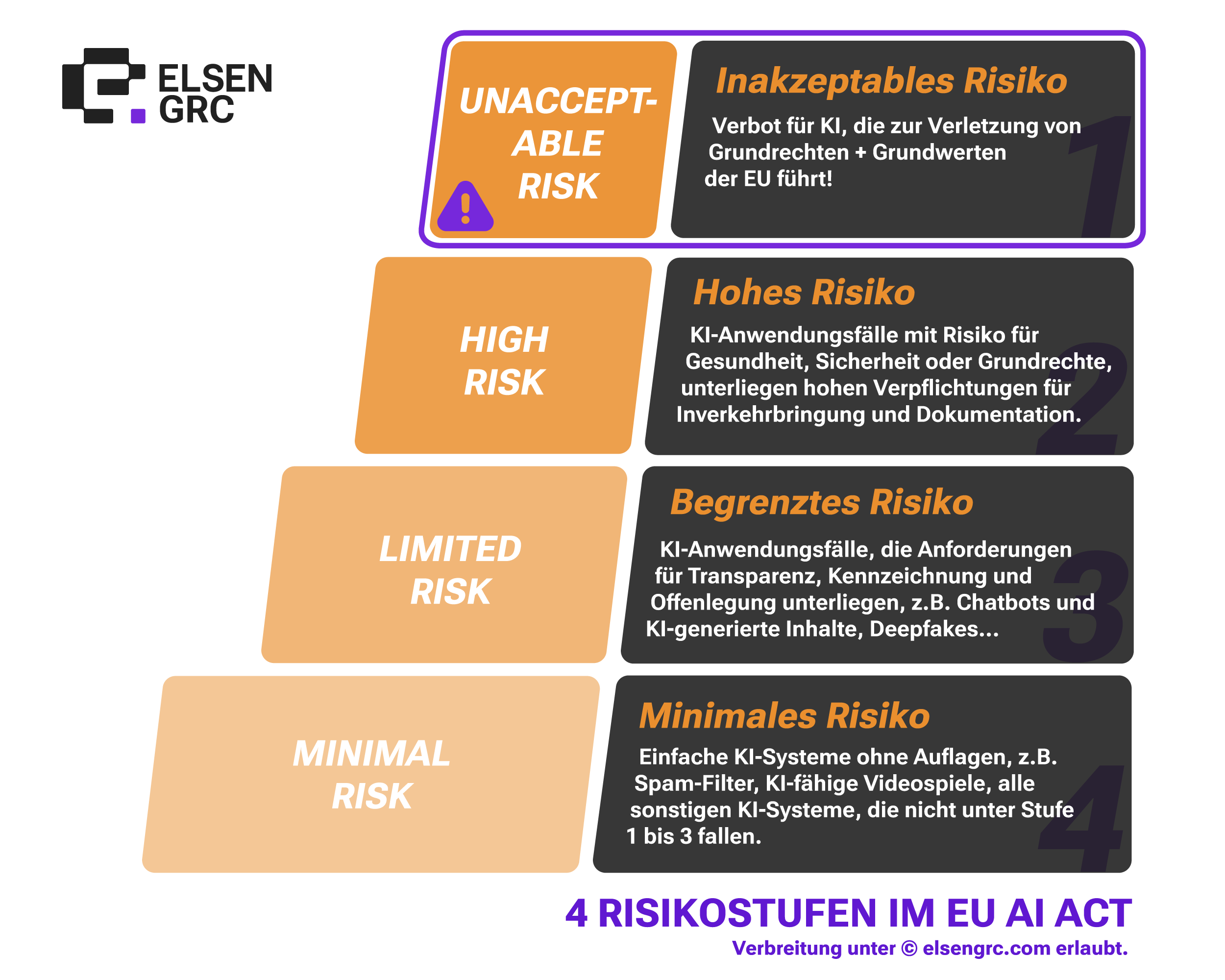

Die Regelungen folgen einem risikobasierten Ansatz, den ich in diesem Beitrag bereits erklärt habe. KI-Systeme werden nach ihrem potenziellen Risiko für die Gesellschaft und die Grundrechte der Menschen in vier Kategorien eingeteilt:

- Verbotene KI-Systeme: Anwendungen, die manipulativ, diskriminierend oder unvereinbar mit den Grundrechten sind.

- Hochrisiko-KI: Systeme in sensiblen Bereichen wie Medizin, Personalwesen, Kreditvergabe oder kritischer Infrastruktur.

- Begrenztes Risiko: Systeme mit Transparenzpflichten, etwa Chatbots oder Empfehlungssysteme.

- Minimales Risiko: Anwendungen wie Spam-Filter oder Spiele-KI, die kaum reguliert sind.

Die folgende Grafik fasst die vier Risikostufen noch einmal zusammen:

Der AI Act wird schrittweise ab 2026 wirksam. Kürzlich wurden einige Übergangsfristen für den EU AI Act bis 2027 verlängert. Unternehmen müssen dann nachweisen, dass sie ihre KI-Systeme korrekt eingestuft, dokumentiert und gegebenenfalls konformitätsbewertet haben. Frühzeitiges Handeln ist daher entscheidend, um Haftungsrisiken zu vermeiden und Wettbewerbsvorteile zu sichern.

Die drei Hauptrollen im AI Act

Ob und in welchem Umfang der AI Act gilt, hängt maßgeblich von der Rolle des Unternehmens ab. Die Verordnung unterscheidet drei Hauptrollen: Anbieter (Provider), Nutzer (Deployer) und Importeur (bzw. Händler). Aber was macht diese Rollen genau aus?

Anbieter (Provider)

Anbieter bzw. Provider sind alle Arten von Unternehmen, die ein KI-System entwickeln, in eigene Produkte integrieren (z.B. als eigene Chatbot-Engine) oder es unter eigenem Namen vertreiben. Ein Beispiel wäre ein SaaS-Unternehmen, das ein Tool zur automatischen Bearbeitung von Kundenanfragen anbietet. Der Provider trägt die Hauptverantwortung für die technische Dokumentation, die Risikobewertung und die Einhaltung aller regulatorischen Anforderungen, die sich aus seinem Angebot von KI-(integrierten) Systemen ergeben.

Nutzer / Einsetzer (Deployer)

Nutzer sind Organisationen, die ein KI-System zur eigenen Leistungserbringung einsetzen oder diese in eigene digitale Prozesse integrieren. Dazu gehört etwa ein Unternehmen, das ein Bewerber-Scoring-Tool eines Drittanbieters verwendet, mit dem die KI-gestützte Verarbeitung von Bewerberinformationen abläuft. Nutzer müssen sicherstellen, dass das verwendete System konform mit dem AI Act ist, und die Nutzung nachvollziehbar dokumentieren.

Importeur / Händler

Diese Rolle betrifft Unternehmen, die KI-Systeme aus Drittstaaten in die EU einführen oder hier vertreiben. Ein Reseller, der ein US KI-Tool in Europa anbietet, fällt also unter diese Kategorie. Importeure und Händler müssen überprüfen, ob das Produkt den europäischen Anforderungen entspricht und korrekt gekennzeichnet ist, bevor es „hier“ eingesetzt wird.

Achtung: In der Praxis können Unternehmen auch mehrere dieser Rollen gleichzeitig einnehmen, etwa wenn sie ein eigenes Modell entwickeln, aber zusätzlich externe KI-Komponenten in ihre Produkte integrieren. Gerne beraten wir Sie bei der Klassifizierung und Einschätzung, in welche Rolle Ihr Unternehmen fällt.

Für wen gilt der EU AI Act? Entscheidungshilfe für Unternehmen

Diese interaktive Entscheidungshilfe zeigt, ob Ihr Unternehmen unter den EU AI Act fällt. Beantworten Sie die folgenden Fragen. Wenn Sie eine Frage mit Ja beantworten, sehen Sie Ihr Ergebnis. Bei Nein geht es mit der nächsten Frage weiter.

1. Entwickeln oder trainieren Sie ein eigenes KI-System?

Beispiele: Entwicklung eines Chatbots, Machine-Learning-Modells für Prognosen, Bilderkennung oder Sprachverarbeitung.

Sie sind Anbieter (Provider).

Der AI Act gilt direkt. Pflichten: Konformitätsprüfung, technische Dokumentation, EU-Datenbankeintrag.

2. Nutzen Sie KI-Funktionen innerhalb Ihrer Produkte oder Prozesse?

Beispiele: Verwendung von ChatGPT, Copilot oder KI-Modellen in internen Workflows, Support-Tools oder Entscheidungsunterstützung.

Sie sind Nutzer (Deployer).

Der EU AI Act gilt indirekt. Pflichten: Nutzung dokumentieren, Transparenz und Zweckbindung prüfen.

3. Vertreiben Sie Software oder Hardware mit integrierter KI in der EU?

Beispiele: Verkauf von Smart-Cams, KI-gesteuerten Tools oder Softwarelösungen mit automatisierter Analyse oder Empfehlungssystemen.

Sie sind Importeur oder Händler.

Pflichten: EU-Konformität und Kennzeichnung sicherstellen.

4. Binden Sie KI-APIs oder fremde Modelle in Ihre Systeme ein?

Beispiele: Nutzung externer KI-APIs (z. B. OpenAI, Google Vertex, HuggingFace) zur Text-, Sprach- oder Bildverarbeitung.

Gemeinsame Verantwortlichkeit möglich.

Empfohlen: Dokumentation, Auftrags- und Vertragsprüfung.

5. Erbringen Sie Dienstleistungen auf Basis externer KI (z. B. Text-, Bild-, Datenanalyse)?

Indirekte Betroffenheit.

Empfohlen: KI-Quellen dokumentieren, Risiken bewerten.

Regelmäßige Überprüfung empfohlen.

Praxisbeispiele für betroffene Unternehmen

Direkt betroffen:

- Ein SaaS-Anbieter entwickelt ein KI-Scoring-Modell für Bewerbungen. Das System fällt in die Hochrisiko-Kategorie und unterliegt den vollen Pflichten des AI Act.

- Eine Agentur entwickelt ein Tool zur automatischen Verarbeitung von Website-Besucherdaten und Profil-Erstellung via KI. Auch hier gelten die Pflichten des AI Acts.

Indirekt betroffen:

- Ein mittelständisches Unternehmen nutzt ein externes KI-Tool für seine Kundensegmentierung. Es bleibt verantwortlich für den sicheren und konformen Einsatz, auch wenn die Technologie von einem Dritten (z.B. SaaS-Anbieter) stammt.

- Ein Personalberater verwendet Copilot für die Optimierung von Bewerberunterlagen, bevor diese an eine dritte Firma weitergereicht werden.

Derzeit nicht betroffen:

- Eine Webagentur, die ausschließlich klassische Websites erstellt und keine KI-Komponenten einsetzt, unterliegt aktuell nicht dem AI Act, sollte jedoch die Entwicklung beobachten und die Integration von externen Tools in ihre eigenen Dienste und Prozesse streng kontrollieren.

- Weitere Unternehmen oder Einrichtungen wie Ärzte, Verbände oder Vereine können möglicherweise (derzeit) noch nicht durch den AI Act betroffen sein, was sich mit dem nächsten Update von Betriebssystemen mit KI-Integration schnell ändern könnte. Gerne beraten wir Sie, ob Ihr Unternehmen schon heute vom AI Act betroffen ist.

Allgemeine Handlungsempfehlung und Fazit

Als Unternehmen sollten Sie den Einstieg in die AI-Act-Compliance strukturiert angehen und – ganz wichtig: keine Panik bekommen! Wie so oft beschließen die Bürokraten aus Brüssel kritische Verordnungen, die dann „durch uns in der Praxis“ umgesetzt werden müssen, ungeachtet der Konsequenzen. Auch wenn der Gedanke sicherlich nicht verkehrt ist, den Einsatz von KI an bestimmte gesetzliche Vorgaben zu knüpfen, bedeutet es in erster Linie, dass europäische Unternehmen zunächst einen Wettbewerbsnachteil erfahren, da entsprechende Vorschriften umgesetzt und dokumentiert werden müssen. Frühzeitige Vorbereitung ist aber nicht nur eine Frage der Compliance, sondern kann auch ein Wettbewerbsvorteil sein. Unternehmen, die ihre Rollen und Pflichten jetzt klar definieren, können Risiken minimieren, Vertrauen schaffen und sich strategisch besser im Markt positionieren.

Damit sich trotzdem die gesetzlichen Rahmenbedingungen einhalten lassen, empfehle ich Ihnen das folgende Vorgehen :

- Zunächst empfiehlt sich eine Bestandsaufnahme, um zu erfassen, wo im Unternehmen oder in den Produkten KI eingesetzt wird. Trommeln Sie Ihre Projektmanager, IT-Leiter und ein paar Entwickler zusammen und diskutieren Sie gemeinsam, an welchen Orten, Diensten und Prozessen im Unternehmen überhaupt KI eingesetzt wird. Von ChatGPT am Arbeitsplatz hin zu maschineller Datenverarbeitung von Kundendaten im Data-Warehouse. Wo es nicht klar ist, reicht zunächst auch ein dickes „?“!

- Im zweiten Schritt folgt die Risikoklassifizierung, bei der jedes System einer der vier Risikostufen zugeordnet wird. Anschließend sollten Verantwortlichkeiten, Prozesse und technische Nachweise im Rahmen einer internen Governance-Struktur festgelegt werden. In diesem Schritt wird also dokumentiert, informiert und abgewägt.

- Abschließend bietet sich ein AI Act Readiness Check an, um den aktuellen „Erfüllungsgrad“ zu bestimmen und konkrete Maßnahmen für Ihre Produkte und Leistungen abzuleiten.

Elsen GRC unterstützt Unternehmen bei diesem Prozess mit einem strukturierten „AI Act Readiness Scan“, der den Compliance-Status ermittelt und konkrete Handlungsempfehlungen liefert. In diesem Check führen wir nicht nur eine strukturierte Bestandsaufnahme und Risikoklassifizierungen durch, sondern liefern auch technische Vorschläge für Optimierungsmaßnahmen an Services und Produkten mit, die Ihren Erfüllungsgrad im AI Act nicht benachteiligen.

Als zertifizierter Datenschutzbeauftragter und Gründer von Elsen GRC in Hamburg unterstütze ich Unternehmen und Behörden dabei, KI-, Cloud- und SaaS-Lösungen sicher und DSGVO-konform einzusetzen. Mit über 14 Jahren Erfahrung in der Software-Entwicklung agiere ich dabei nicht nur mit einem klaren Blick auf regulatorische Anforderungen, sondern unterstütze Sie und Ihre IT bei der technischen Umsetzung der oftmals trockenen und praxisfernen Gesetze.

Mario Elsen, Geschäftsführer Elsen Media GmbH

Quellen:

- Europäische Kommission: EU AI Act – Offizieller Text (2024)

- Elsen GRC interne Analyse 2025

Titelbild: Mick Haupt – Unsplash.com

One Comment